Innspill fra KIN, av Pål H. Brekke, MD PhD, mai 2023. (Skrevet uten hjelp av generative språkmodeller.)

Språkteknologi (NLP - natural language processing) har vært forsket på og delvis utprøvd i mange år. Med utviklingen og distribusjonen av ChatGPT fra OpenAI og beslektede store språkmodeller fra nett-giganter som Meta og Google, fikk teknologien et tydelig gjennombrudd i slutten av 2022. De store språkmodellene har blitt en del av både samfunnsdebatten og den faglige debatten innen medisin – allerede i mai 2023 finner man over 500 publikasjoner på PubMed ved et søk på «ChatGPT», bare et halvt år etter at tjenesten ble annonsert.

Det forrige store kvantespranget innen NLP skjedde med de første transformer-baserte AI-modellene, og spesifikt BERT-familien (Bidirectional Encoder Representations from Transformers) som ble publisert i 2018. Med disse modellene ble det mulig å maskinelt fortolke de viktige meningsbærende elementene i en tekst og å skille homonymer, og BERT-avledede modeller inngår allerede i de fleste språk-relaterte tjenester vi er vant til å bruke i det daglige, som Google-søk, chatboter (før chatGPT), auto-complete/tekstforslag, og analytiske funksjoner som sentiment-analyse og informasjonsekstrasjon.

Det som i det siste har fanget mye oppmerksomhet i alle fagfelt er den neste utviklingen av transformer-baserte modeller laget spesielt for generative oppgaver (GPT – generative pre-trained transformer). Disse AI-modellene er designet for å «generere» neste ord eller neste setning, og optimalisert for bruksområder som å svare på spørsmål, holde en dialog og skape tekst/innhold. Den nyeste generasjonen transformer-baserte språkmodeller har også fått større kapasitet til å forstå kontekst. Forrige generasjon (fram til høsten 2022) språkmodeller kunne hensynta inntil noen tusen tegn i analysen, mens GPT-modellene tar med flere tusen ORD i konteksten.

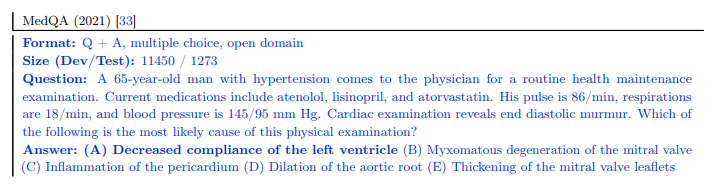

For å illustrere hvor raskt utviklingen av språkmodeller har gått, er det interessant å se på hvordan NLP-modellene har scoret på mer avanserte språkoppgaver som MedQA (spørsmål fra amerikanske eksamensoppgaver i medisin; USMLE – se eksempel under). State-of-the-art korrekt svarprosent på MedQA var 47.5% i november 2022. Den første språkmodellen som scoret over 50% (BioMedML, 50.3%) er laget i et samarbeid mellom Stanford og MosaicML og ble publisert den 15. desember 2022. Google DeepMinds Med-PALM ble sluppet i romjulen og scoret 67.3%, og ble med det den første AI-modellen som ville «bestått eksamen». I februar og mars kom GPT-4 og Med-PALM 2 med score på henholdsvis 81.2% og 85.4%. Disse nye språkmodellene representerer åpenbart et kvantesprang i tekst-tolkning.

Også i årene før GPT-baserte modeller overtok det meste av oppmerksomheten, har det eksistert kommersielle og forskningsrettede NLP-løsninger spesielt tilpasset helsevesenet. Amazon har i flere år solgt tjenesten «Comprehend Medical» som trekker ut måle- og tellbare data fra fritekst, likeledes har Spark NLP og andre leverandører solgt NLP-løsninger som kan trekke ut informasjon om medikamenter, symptomer, diagnoser, radiologifunn, osv. fra typiske journaldokumenter. Mayo Clinic og andre store sykehus-organisasjoner i USA og i andre land har benyttet seg av NLP for å berike sine datavarehus og prediksjonsmodeller. Det finnes tusenvis av forskningspublikasjoner bare i medisinske tidsskrifter om slik teknologi fra det siste tiåret, med en eksponentiell økning i antall for hvert år.

Fritekst = struktur

Et av de viktigste bruksområdene for språkteknologi i medisin i nær framtid vil trolig være ekstraksjon av målbare datapunkter fra fritekst. En nylig forstudie av Adams og medarbeidere i Radiology (april 23) viser at GPT-4 vellykket kan transformere radiologi-beskrivelser (MR, CT og vanlig røntgen) til rapportstrukturer. Informasjonsekstraksjon vil potensielt ha stor betydning for virksomhetsrapportering, kvalitetssikring og forskning, og vil også kunne gjøre medisinske IKT-systemer langt mer menneskevennlige, da klinikere ikke vil måtte mate data inn i skjemaer. Informasjons-ekstraksjon handler ikke bare om diagnoser, prosedyrer, funn, medikamenter, målinger, symptomer og funn, men også om beslutninger, oppgaver og tiltak, som igjen kan benyttes til økt automatisering av prosesser. I dette feltet er mulighetene betydelige.

Et bruksområde for NLP som ofte blir tatt fram som et eksempel er oppsummering av en lang og kompleks sykehistorie. LLMer er godt egnet til slike oppgaver, men her må man muligens ta et forbehold om risiko for en ny type feil, da de nåværende GPT-baserte modellene har en tendens til såkalte “hallusinasjoner”, et fenomen der fullstendig falske data presenteres overbevisende som sannhet. Mer om dette i senere avsnitt. En nylig artikkel av Lee og medarbeidere i NEJM (mars 23) omtaler forsøk på å lage automatiske journalnotater med GPT-4, der forfatterne oppdaget at AI-modellen nettopp “diktet opp” blant annet et BMI-svar som det ikke fantes grunnlag for i råmaterialet. Ved å bruke ytterligere en GPT-4-modell til “korrekturlesning” klarte de å identifisere denne og andre feil, men det gjenstår sannsynligvis avklaringer både mht risiko og på det regulatoriske før denne typen fortolkninger/sammendrag kan benyttes i klinikken – i hvert fall innen EU. Mer om reguleringer i et senere avsnitt.

Øvrige eksempler på oppgaver NLP-verktøy kan brukes til i medisin oppsummeres kort under – merk at listen ikke er uttømmende:

- Svare på spørsmål – enten ved å fortolke et spørsmål i menneskelig språk slik at det matcher det riktige forhåndsdefinerte svaret, f.eks. en beskrivelse av en operasjon, eller som i en chat-robot der teksten som produseres også er dynamisk.

- Tekstprediksjon/autokorrektur – modellene kan foreslå neste ord basert på det man skriver i kontekst.

- Tekstgenerering – lage hele artikler om et emne basert på brukerens bestilling. Kanskje ikke veldig relevant i klinikk, men et bruksområde er syntetiske journaler til test- og opplæringsbruk.

- Sentiment-analyse – klassifisere om meninger i tekst er positive, negative eller nøytrale. Innen helse kan dette for eksempel benyttes i PREM/PROM-sammenheng.

- Dokumentklassifisering - å sortere dokumenter til riktig mottaker, for eksempel henvisninger, er i dag i stor grad menneskearbeid, men mye av dette bør kunne overlates til NLP-modeller.

- Oversettelse – både oversettelse mellom ulike menneskelige språk, og oversettelse fra menneske- til maskinspråk (hjelp til programmering) er aktuelle innen helse.

Et lite sidespor: Fra RNA til proteinstruktur

Et virkelig stort AI-gjennombrudd innen medisin og biologi kom i 2020 da Googles DeepMind annonserte AlphaFold, et verktøy som brukte komplekse kombinasjoner av AI-modeller og innkodet kunnskap for å utlede proteiners 3D-struktur ut fra en aminosyresekvens. Dermed økte vår kjennskap til proteinstrukturer til å omfatte hundretusenvis. I 2021 startet publiseringen av en struktur-database med over 350.000 proteiner, inkludert de rundt 20.000 kjente proteinene i mennesket, og sommeren 2022 ble databasen utvidet til over 200 millioner strukturer fra alle slags organismer.

I 2023 kastet Meta seg også på proteinfoldings-problemet, men deres tilnærming var å bruke en stor språkmodell – oppgaven kan tross alt sees som et oversettelsesproblem, fra en streng av aminosyrer (som kan forstå som tegn/ord) til et tredimensjonalt kart. Metas modell, ESM-2, har til nå regnet ut og publisert 772 millioner proteinstrukturer. LLM-tilnærmingen viste seg å ha samme presisjon som AlphaFold på en undergruppe proteiner, og var vesentlig raskere i analysen. De første 600 millionene proteinstrukturene ble beregnet i løpet av to uker på 2000 GPU-er.

Også innen andre biomedisinske områder har NLP-modeller gitt spennende og kanskje litt overraskende bidrag. Baidu leverte i begynnelsen av mai 2023 en NLP-modell som optimaliserer mRNA-sekvenser for vaksiner, og man oppnådde en 128-ganger bedre antistoff-respons mot COVID-19 med en NLP-forbedret sekvens.

Ingen effekt uten bivirkninger?

Nåværende generasjon store språkmodeller (kollektivt kalt LLMer – Large Language Models) er trent på gigantiske mengder tekst åpent tilgjengelig på Internett, og selv om de enkelt forklart i utgangspunktet er laget for å forutse hva neste ord i en tekst vil være ut fra konteksten, har de overrasket mange ved å kunne generere svært overbevisende argumentasjon, og tilsynelatende gi gode sammenstillinger av informasjon. Samtidig som de scorer høyt på avanserte fortolkningsoppgaver som MedQA nevnt over, har de også framvist en tendens til såkalte «hallusinasjoner», der AI-modellen dikter opp svar som virker fullstendig tilforlatelige, og disse kan være vanskelige å fange opp for en menneskelig leser.

Siden modellene rent faktisk bare genererer ord basert på sannsynligheter og ikke har noen som helst faktisk forståelse for hva ordene representerer i den virkelige verden, er dette fenomenet ikke helt overraskende, og det er usikkert om denne typen feil lar seg utrydde i GPT-baserte språkmodeller. I likhet med mange typer maskinlæringsmodeller kan feilene som dukker opp være av en karakter som virker vanskelig forklarbare og uvante for brukerne, og dette utfordrer både bruksområder og tillit. I en medisinsk sammenheng vil åpenbart en NLP-modell som ikke sikkert gjengir de faktiske forhold som blir omtalt i en sykehistorie, men dikter opp overbevisende svar, kunne gi svært uheldige følger.

Et menneskelig trekk som gjør oss ekstra sårbare for feil introdusert av AI-modeller er at det synes som vi har større tillit til datamaskiner enn våre kolleger. Allerede i den tidlige digitaliseringsalderen kom det studier som viste at mennesker tror en data-liste er riktigere enn håndskrevet informasjon. Også nyere studier tyder på at vi har mer tiltro til algoritmer enn mennesker (eks. Logg et al, 2019). En helt fersk studie i Radiology (BI-RADS, Dratsch et al, mai 2023) viser at vi også i stor grad lar oss påvirke av AI-svar: Forfatterne testet hvordan radiologer ble påvirket av feilaktige resultater fra et fiktivt AI-verktøy for mammografi. På 12 av 40 bilder ga “AI-verktøyet” en feil diagnose, og dette hadde en veldig sterk effekt på den menneskelige vurderingen av disse bildene, der de minst erfarne var mest påvirkelige.

Også språkmodellene ser ut til å introdusere bias hos brukerne. En svært interessant studie av Jakesch og medarbeidere ble presentert på CHI 23 i Hamburg i april i år. De lot 1500 forsøkspersoner skrive korte innlegg om sosiale mediers effekt på samfunnet, og randomiserte om de fikk benytte generative språkmodeller som var forhåndskodet til å ha enten positive eller negative meninger om temaet. Forsøkspersonene ble testet for sine egne meninger om temaet før og etter at de skrev innleggene. Det fascinerende resultatet i studien er at deltakerne som benyttet språkmodeller endret meninger i tråd med språkmodellenes programmerte oppfatninger - både i sine skriftlige innlegg og i etterfølgende tester.

Skjevheter og datagrunnlag

Siden de fleste AI-modeller er laget ved hjelp av maskinlæring, og læringen er avhengig av grunnlagsdata, er det velkjent at skjevheter i treningsdata vil reflekteres i modellene. GPT-modellene er trent på store tekstmengder tilgjengelig på det åpne internett, og det er neppe kontroversielt å antyde at kvaliteten på mye av det som er publisert på internett er diskutabel. ChatGPT-tjenesten har blitt raffinert ved at tusenvis av personer har veiledet modellen i retning av å gi akseptable svar, men det er ikke usannsynlig at modeller trent på ukontrollert innhold – som et bredt sample av internett – vil inneholde uforutsette skjevheter. Eller også skjevheter som er spesifikt plantet av organisasjoner med legitime eller illegitime interesser. I en tidsalder der vitenskapelige fakta blir undergravet og politisert kan viktig grunnlagsinformasjon om helsespørsmål, som prevensjon, smitte, vaksiner og lignende, sannsynlig bli såpass påvirket at en AI-modell vil reflektere slike skjevheter.

Kunne man tenke seg språkmodeller kun trent på fagfellevurdert litteratur? En kritisk leser av medisinsk og vitenskapelig litteratur vil innvende at en stor prosentandel av det som publiseres er av dårlig metodologisk kvalitet, inneholder skjevheter, at negative studier ikke blir offentliggjort, at industri-sponsede studier tenderer til å være langt mer positive enn ikke-sponsede studier, og så videre. Vi har utviklet metoder for å gradere kvalitet av forskning, men må vel erkjenne at selv en AI-modell trent på publisert faglitteratur i realiteten ikke ville fått det ideelle kunnskapsgrunnlag. I hvor stor grad dette påvirker brukbarheten av språkmodellene som hjelpemidler innenfor medisin er ikke klart. Et viktig spørsmål framover er hvordan vi fletter sammen ideene og prinsippene i kunnskapsbasert medisin med de store språkmodellene.

I klinisk medisin er neppe plagiat et vesentlig problem, men mange forskere har allerede publisert artikler der ChatGPT er listet som medforfatter. En interessant problemstilling i så måte, i tillegg til at modellene som nevnt over faktisk påvirker forfatternes mening, er hvorvidt generert tekst kan være plagiat av andre. En interessant studie av Chang og medarbeidere viser at tekst fra kopibeskyttet materiale lar seg reprodusere ordrett fra ChatGPT og GPT-4. Flere vitenskapelige forlag har innført strengere plagiatkontroll som følge av dette problemet.

Til sist er det et poeng til ettertanke at materiale på internett etter introduksjonen av LLMer faktisk inneholder store mengder materiale produsert nettopp av språkmodeller. Det er et åpent spørsmål hvordan dette vil påvirke treningen av neste generasjon modeller, og om vi allerede har «forurenset grunnvannet», så å si.

Det regulatoriske landskapet

I industrier utenfor helsevesenet har en stor andel selskaper allerede tatt i bruk eller planlegger å ta i bruk LLMer for å effektivisere drift.

Det veldig spennende AI-feltet er at det er ekstremt kort avstand mellom forskning, implementering og regulering. Vi er kanskje heldige i helse-feltet som har etablerte metoder for evaluering av nye verktøy og strenge rammer rundt oss som beskytter mot de mest opportunistiske aktørene?

I Europa har både GDPR og den forholdsvis nye Medical Device Regulation (MDR) betydelig påvirkning på AI-landskapet. GDPR reduserer tilgjengeligheten til medisinske data som kunne ha stor betydning for å trene presise og tilpassede AI-modeller, og MDR gir svært strenge regulering av ethvert programvareprodukt som benyttes innen helse. Siden mai 2021 er software som har som formål å benyttes i diagnostikk, behandling, lindring, forebygging eller prognose, rettet mot individuelle pasienter, etter all sannsynlighet å betrakte som medisinsk utstyr og må gjennom en godkjenningsordning med CE-merking. Dette gjelder uansett om bruksområdet er profesjonelt eller for eksempel en mobil-app laget for vanlige forbrukere. Unntaket er systemer som kun driver med lagring og henting av uendrede helsedata – de fleste transformasjoner av data faller potensielt under MDR.

Foreløpig er det ingen erfaring med CE-merking av NLP-løsinger for helsedata under MDR. Enkelte AI-baserte verktøy for bildebehandling er godkjent etter det nye regulativet, men det er grunn til å tro at sertifisering av løsninger basert på LLMer vil by på nye utfordringer. Det er også mulig at reguleringen vil endres dersom de nye teknologiene viser seg å ha betydelige positive effekter. Det finnes flere gode oppsummeringer av MDR-problemstillingene relatert til GPT på internett. En av de mer lesverdige kommer fra konsulentselskapet Hardian Health og heter «How to get ChatGPT regulatory approved as a medical device». Link nederst i artikkelen.

Uavhengig av bransjespesifikke reguleringer er tilgangen LLMer allerede sterkt demokratisert, og de fleste vil om kort tid ha slike tjenester på sine private mobiltelefon. Det blir interessant å se hvordan disse verktøyene vil bli tatt i bruk uoffisielt/privat av helsepersonell, og av pasienter, og hvordan det vil påvirke helsetjenesten i årene framover. Vil vi oppleve framvekst av samme type helserelaterte spørsmål fra pasientene som bibliotekene har fått fra sine kunder, der leserne ber om ikke-eksisterende bøker fra ikke-eksisterende forfattere, basert på råd fra chatGPT?

«For den som har en hammer…»

Det er kanskje ikke KIN-nettverket som krever en påminnelse om at ikke alle oppgaver som KAN løses med AI nødvendigvis MÅ løses med AI. Som en liten motvekt til entusiasmen knyttet til nye verktøyet er det likevel på sin plass å minne om at man bør starte med et problem som skal løses og så lete etter et verktøy som passer til oppgaven, heller enn å starte med et verktøy og lete etter et bruksområde. Når det er sagt, har NLP-teknologien nå kommet til et stadium der den gir oss en rekke nye muligheter, og så gjelder det å ta disse i bruk på en sikker og ansvarlig måte.

Gitt reguleringene blir det antakelig langt enklere å implementere NLP-verktøy som har formål rettet mot drift, kvalitetssikring og forskning enn løsninger som griper inn i klinikk og behandler medisinsk informasjon rettet mot enkeltpasienter. I implementeringen av sistnevnte blir det en interessant diskusjon om hvem som bærer risiko - særskilt sett i lys av hvor lett påvirkelige vi mennesker er av AI-forslag, som referert over.

Inntoget av de kraftige NLP-verktøyene reiser en hel rekke spennende spørsmål innen mange industrier, og ekstra mange innen helse. Vi lever i en spennende tid!

Et lite PS om antropomorfisme

Et interessant utslag av at de nye NLP-modellene danner tekst av høy kvalitet, er at vi som mennesker får problemer med å fortolke hva som egentlig foregår i bakgrunnen. Dette ble tydelig illustrert av oppslagene sommeren 2022 da en Google-ansatt mente at deres samtale-AI «LaMDA» var bevisst og måtte betraktes som et levende vesen. Han fikk endog hyret inn en advokat for at den skulle få forsvart sine rettigheter(!). Har vi som mennesker begrepsapparat og forståelse som dekker den teknologien vi nå står ovenfor, og hva slags konsekvenser vil det ha for ibruktakelse og regulering?

Referanser og bakgrunnsmateriale

Devlin et al: BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

https://arxiv.org/abs/1810.04805

Singhal et al: Large Language Models Encode Clinical Knowledge

https://arxiv.org/pdf/2212.13138.pdf

Charlotte Haug et al: Artificial Intelligence and Machine Learning in Clinical Medicine, 2023

https://www.nejm.org/doi/full/10.1056/NEJMra2302038

Adams et al: Leveraging GPT-4 for Post Hoc Transformation of Free-text Radiology Reports into Structured Reporting: A Multilingual Feasibility Study

https://pubs.rsna.org/doi/epdf/10.1148/radiol.230725#

The GPT-4 Episode: Microsoft’s Peter Lee on the Future of Language Models in Medicine (NEJM podcast)

https://ai-podcast.nejm.org/e/microsoft-s-peter-lee-on-the-future-of-language-models-in-medicine/

Highly accurate protein structure prediction with AlphaFold

https://www.nature.com/articles/s41586-021-03819-2

Evolutionary-scale prediction of atomic-level protein structure with a language model

https://www.science.org/doi/10.1126/science.ade2574

Zhang et al: Algorithm for Optimized mRNA Design Improves Stability and Immunogenicity https://www.nature.com/articles/s41586-023-06127-z

Logg et al: Algorithm appreciation: People prefer algorithmic to human judgment

https://www.sciencedirect.com/science/article/abs/pii/S0749597818303388

Jakesch et al: Co-Writing with Opinionated Language Models Affects Users' Views:

https://dl.acm.org/doi/pdf/10.1145/3544548.3581196

Lee et al, Benefits, Limits, and Risks of GPT-4 as an AI Chatbot for Medicine

https://www.nejm.org/doi/10.1056/NEJMsr2214184

Dratsch et al: Automation Bias in Mammography: The Impact of Artificial Intelligence BI-RADS Suggestions on Reader Performance

https://pubs.rsna.org/doi/10.1148/radiol.222176

Chang et al: Speak, Memory: An Archaeology of Books Known to ChatGPT/GPT-4

https://arxiv.org/abs/2305.00118

Guidance on Qualification and Classification of Software in Regulation (EU) 2017/745 – MDR and Regulation (EU) 2017/746 – IVDR

https://ec.europa.eu/docsroom/documents/37581

Hardian Health: How to get ChatGPT regulatory approved as a medical device

https://www.hardianhealth.com/blog/how-to-get-regulatory-approval-for-medical-large-language-models